阿里云通义大模型新技术:MoE模型训练专家平衡的关键细节

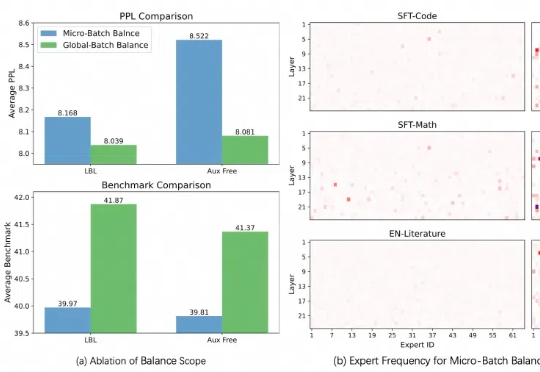

阿里云通义大模型新技术:MoE模型训练专家平衡的关键细节本周,在阿里云通义千问 Qwen 团队提交的一篇论文中,研究人员发现了目前最热门的 MoE(混合专家模型)训练中存在的一个普遍关键问题,并提出一种全新的方法——通过轻量的通信将局部均衡放松为全局均衡,使得 MoE 模型的性能和专家特异性都得到了显著的提升。

本周,在阿里云通义千问 Qwen 团队提交的一篇论文中,研究人员发现了目前最热门的 MoE(混合专家模型)训练中存在的一个普遍关键问题,并提出一种全新的方法——通过轻量的通信将局部均衡放松为全局均衡,使得 MoE 模型的性能和专家特异性都得到了显著的提升。

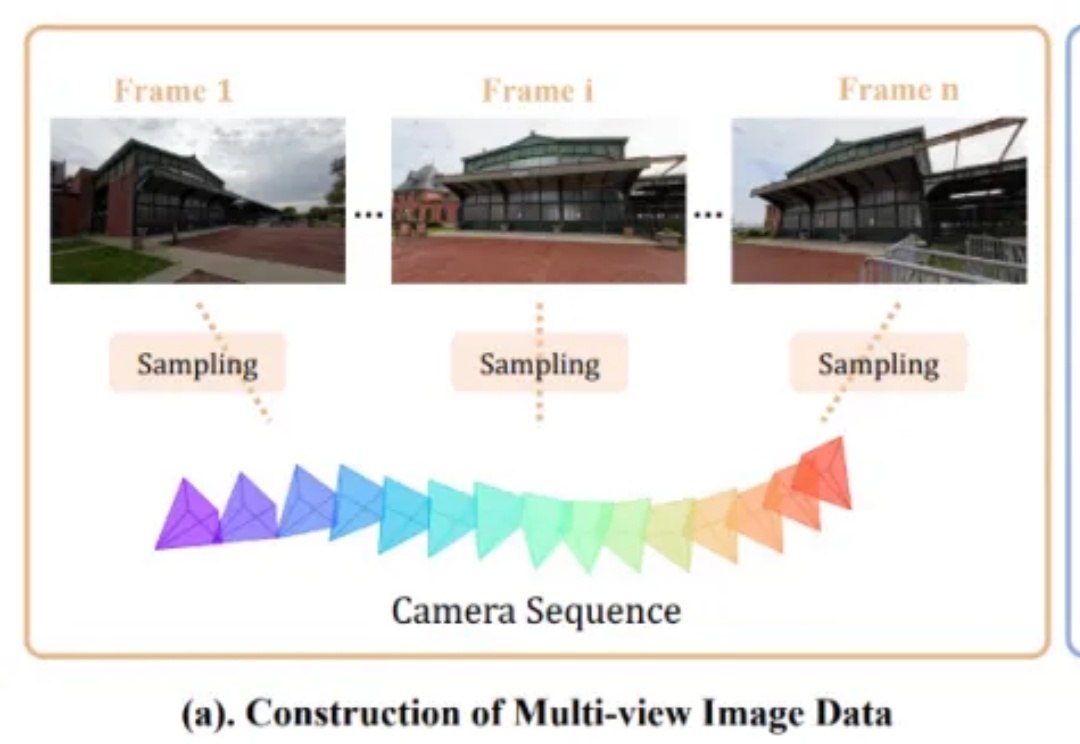

视觉版o1的初步探索,阶跃星辰&北航团队推出“慢感知”。研究人员认为:1)目前多模领域o1-like的模型,主要关注文本推理,对视觉感知的关注不够。2)精细/深度感知是一个复杂任务,且是未来做视觉推理的重要基础。

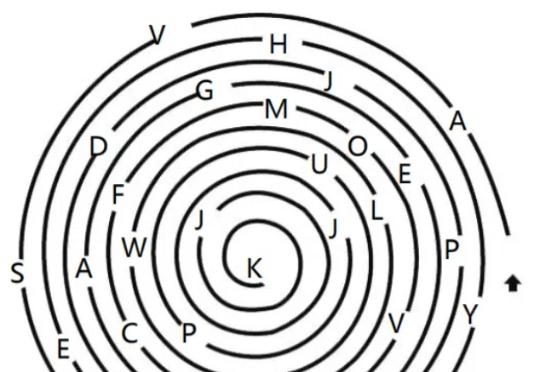

随着大模型(LLMs)的发展,AI 写作取得了较大进展。然而,现有的方法大多依赖检索知识增强生成(RAG)和角色扮演等技术,其在信息的深度挖掘方面仍存在不足,较难突破已有知识边界,导致生成的内容缺乏深度和原创性。

非营利研究机构AI2近日推出的完全开放模型OLMo 2,在同等大小模型中取得了最优性能,且该模型不止开放权重,还十分大方地公开了训练数据和方法。

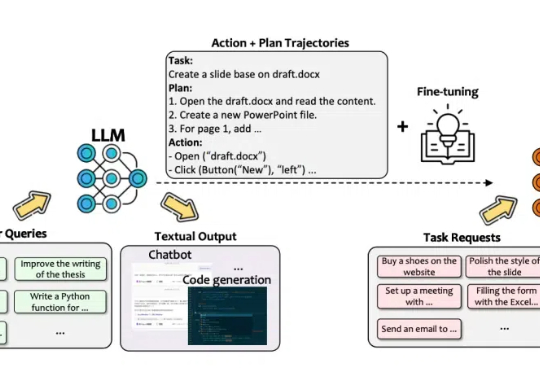

AI智能体正悄然成为我们工作和生活中的得力助手。从自动化任务到复杂规划,它们不仅能帮我们做市场调研、准备面试,还能完成复杂的决策任务。

瞄准推理时扩展(Inference-time scaling),DeepMind新的进化搜索策略火了! 所提出的“Mind Evolution”(思维进化),能够优化大语言模型(LLMs)在规划和推理中的响应。

OpenAI的新Scaling Law,含金量又提高了。

苏格拉底曾提到的门诺悖论(Meno's paradox)认为,人只能学会自己已经知道的事情;而关于AI辅助编程,谷歌资深工程师最近的一篇博客告诉我们,类似的知识悖论同样存在。

OpenAI 在 “双十二” 发布会的最后一天公开了 o 系列背后的对齐方法 - deliberative alignment,展示了通过系统 2 的慢思考能力提升模型安全性的可行性。

未来,掌握持续提示工程技术的开发者,将主导下一代智能系统的进化方向。

新年第一天,陈天奇团队的FlashInfer论文出炉!块稀疏、可组合、可定制、负载均衡......更快的LLM推理技术细节全公开。

ChatGPT等聊天机器人背后的算法能从各种各样的网络文本中抓取万亿字节的素材,文本来源可以是网络文章,也可以是社媒平台的帖子,还可以是视频里的字幕或评论。

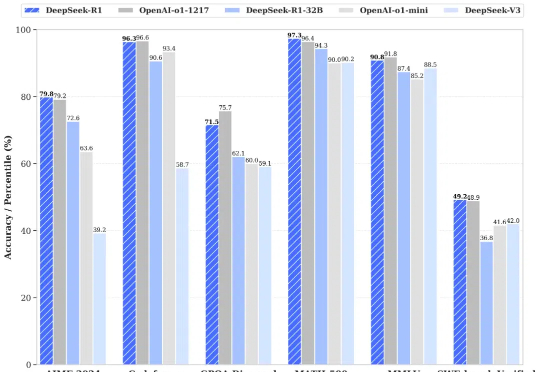

时隔不到一个月,DeepSeek又一次震动全球AI圈。去年 12 月,DeepSeek推出的DeepSeek-V3在全球AI领域掀起了巨大的波澜,它以极低的训练成本,实现了与GPT-4o和Claude Sonnet 3.5等顶尖模型相媲美的性能,震惊了业界。

研究者提出了FAST,一种高效的动作Tokenizer。通过结合离散余弦变换(DCT)和字节对编码(BPE),FAST显著缩短了训练时间,并且能高效地学习和执行复杂任务,标志着机器人自回归Transformer训练的一个重要突破。

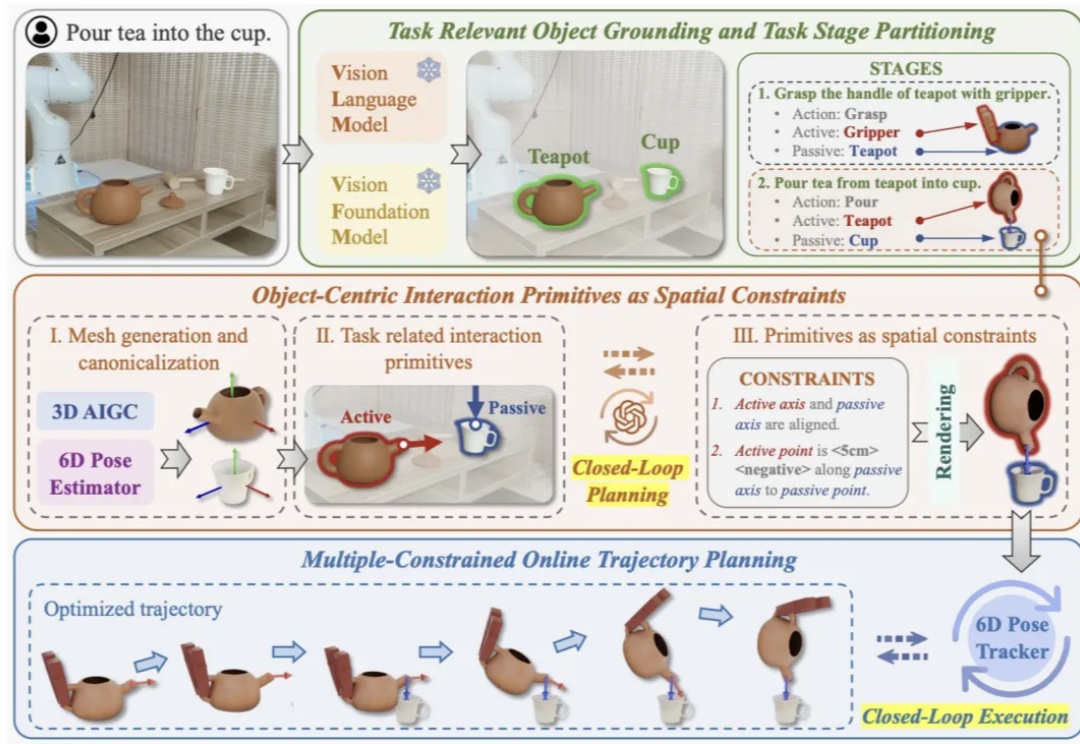

近年来视觉语⾔基础模型(Vision Language Models, VLMs)在多模态理解和⾼层次常识推理上⼤放异彩,如何将其应⽤于机器⼈以实现通⽤操作是具身智能领域的⼀个核⼼问题。这⼀⽬标的实现受两⼤关键挑战制约:

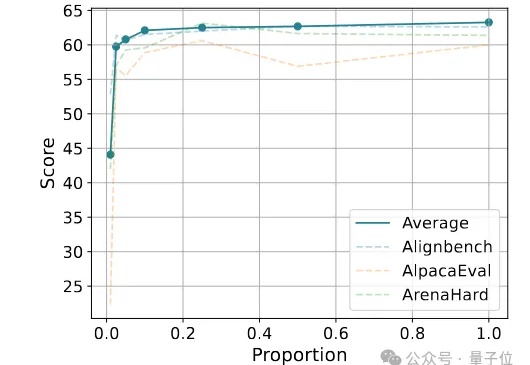

仅使用20K合成数据,就能让Qwen模型能力飙升——

可灵,视频生成领域的佼佼者,近来动作不断。继发布可灵 1.6 后,又公开了多项研究揭示视频生成的洞察与前沿探索 ——《快手可灵凭什么频繁刷屏?揭秘背后三项重要研究》。

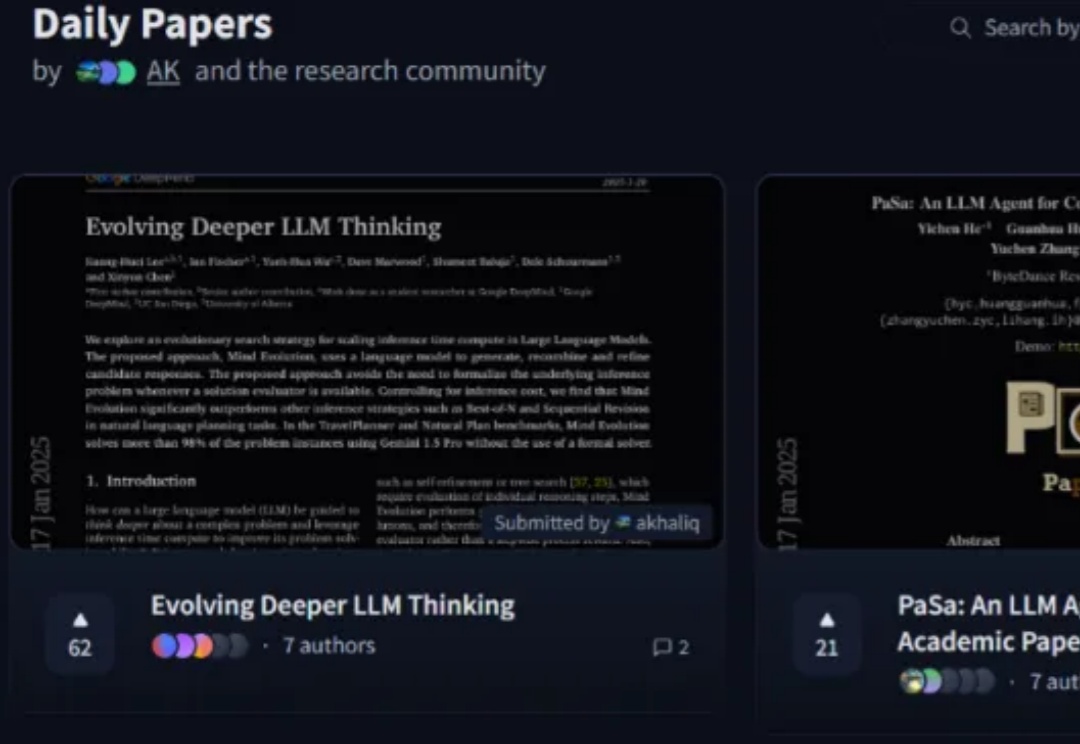

今天是个好日子,DeepSeek 与 Kimi 都更新了最新版的推理模型,吸引了广泛关注。与此同时,谷歌 DeepMind、加州大学圣地亚哥分校、阿尔伯塔大学的一篇新的研究论文也吸引了不少眼球,并直接冲上了 Hugging Face 每日论文榜第一(1 月 20 日)。

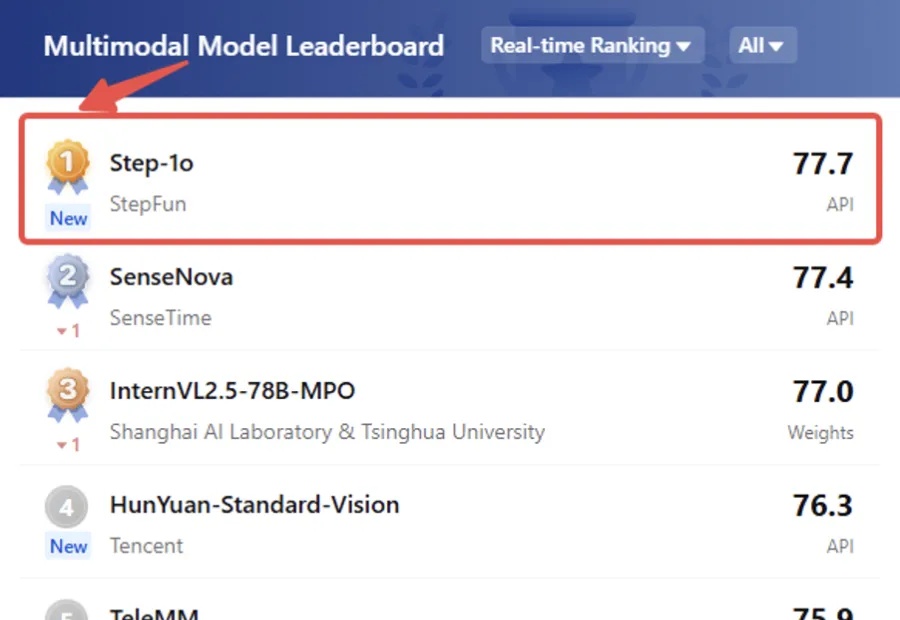

我勒个老天奶,大模型六小强之一的阶跃星辰,给大家拜早年的方式可真不一样——

2024年,智元机器人与北大成立联合实验室,8月发布“远征”与“灵犀”两大系列共五款商用人形机器人新品,10月旗下灵犀X1人形机器人官宣开源,12月宣布正式开启通用机器人量产,不断拓展应用场景。

北京大学信息工程学院田永鸿教授、陈杰副教授,联合广州国家实验室周鹏研究员指导博士生聂志伟、硕士生刘旭东等,提出了一种进化驱动的病毒变异驱动力预测框架 E2VD,可以对新冠病毒、流感病毒、寨卡病毒、艾滋病病毒进行预测。

就在刚刚,Verses团队研发的Genius智能体,在Pong中超越了人类顶尖玩家!而且它仅仅训练2小时,用了1/10数据,就秒杀了其他顶级AI模型。

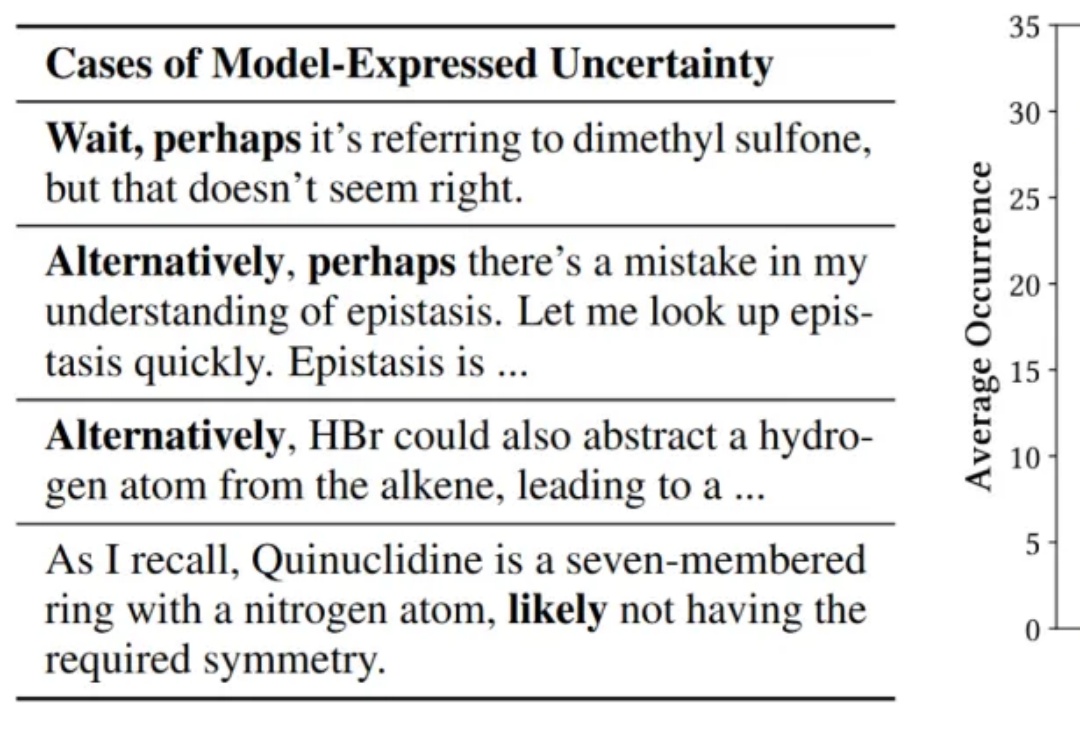

人大清华团队提出Search-o1框架,大幅提升推理模型可靠性。尤其是「文档内推理」模块有效融合了知识学习与推理过程,在「搜索+学习」范式基础上,使得模型的推理表现与可靠性都更上一层楼。

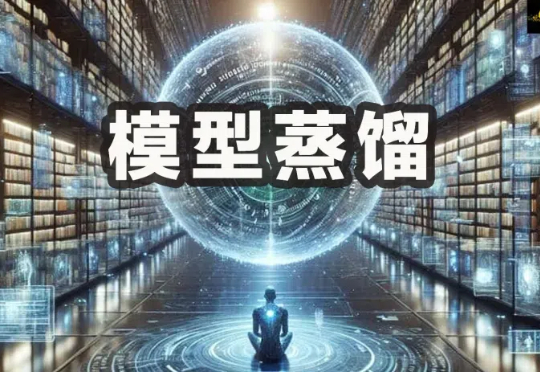

模型蒸馏也有「度」,过度蒸馏,只会导致模型性能下降。最近,来自中科院、北大等多家机构提出全新框架,从两个关键要素去评估和量化蒸馏模型的影响。结果发现,除了豆包、Claude、Gemini之外,大部分开/闭源LLM蒸馏程度过高。

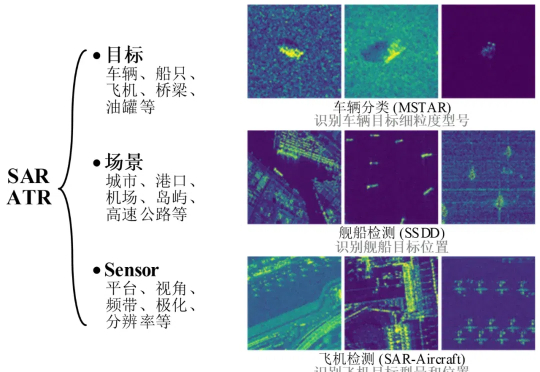

在人工智能基础模型技术飞速发展的今天,SAR 图像解译领域技术创新与发展生态亟待突破。为了解决上述技术挑战,国防科技大学电子科学学院刘永祥&刘丽教授团队提出首个公开发表的SAR图像目标识别基础模型SARATR-X 1.0。

该技术报告的主要作者 Lu Wang, Fangkai Yang, Chaoyun Zhang, Shilin He, Pu Zhao, Si Qin 等均来自 Data, Knowledge, and Intelligence (DKI) 团队,为微软 TaskWeaver, WizardLLM, Windows GUI Agent UFO 的核心开发者。

昨天晚上,DeepSeek 又开源了 DeepSeek-R1 模型(后简称 R1),再次炸翻了中美互联网: R1 遵循 MIT License,允许用户通过蒸馏技术借助 R1 训练其他模型。 R1 上线 API,对用户开放思维链输出 R1 在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版,小模型则超越 OpenAI o1-mini

设想一场高度智能的模拟游戏,游戏的角色不再是普通的NPC,而是由大语言模型驱动的智能体。在这其中,悄然生出一个趣事——在人类的设计下,这些新NPC的言行不经意间变得过于啰嗦。

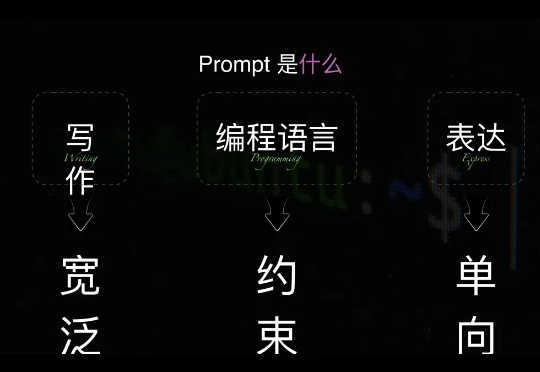

李继刚在消失半年后,带着汉语新解重新归来,一出手大家就惊呼李继刚的prompt已经到了next level。但不懂编程的小白又懵逼了!怎么提示词也开始编程了?大语言模型的优势不是通过说话就能达成需求吗?怎么又开始需要编程了?技术在倒退吗?

近期关于 scaling law 的讨论甚嚣尘上,很多观点认为 scale law is dead. 然而,我们认为,高质量的 “无监督” 数据才是 scaling law 的关键,尤其是教科书级别的高质量的知识语料。此外,尽管传统的语料快枯竭了,但是互联网上还有海量的视频并没有被利用起来,它们囊括了丰富的多种模态的知识,可以帮助 VLMs 更好好地理解世界。